Een team van Duitse onderzoekers publiceerde een studie begin deze week waaruit blijkt dat mensen ertoe gebracht kunnen worden een robot aan te laten staan, simpelweg omdat deze erom "vraagt". Het probleem wordt personificatie genoemd en het zou voor onze soort problemen kunnen veroorzaken naarmate machines meer geïntegreerd raken in onze samenleving.

Robots, als we de media moeten geloven, vormen de grootste existentiële bedreiging voor de mensheid sinds de atoombom. In films komen ze in opstand en doden ze ons met kogels en lasers, en in de krantenkoppen nemen ze ieders banen over. Maar dystopische nachtmerries zijn niet altijd zo duidelijk. De realiteit, althans voor nu, is dat robots dom zijn – nuttig, maar dom – en dat mensen alle macht hebben.

Nou, bijna alle macht. Het blijkt dat als een robot een persoon vraagt om hem aan te laten staan, de mens eerder geneigd is om hem aan te laten dan wanneer hij niets zegt. Dat klinkt misschien als een open deur, maar de implicaties van het onderzoek zijn eigenlijk angstaanjagend wanneer je ze in context bekijkt.

In totaal deden 85 mensen mee aan de studie. Om te bepalen of deelnemers zouden aarzelen om een robot uit te schakelen die hen net had gevraagd dat niet te doen, stelde het team verschillende controles in.

De deelnemers aan het experiment stemden ermee in om met een robot te interageren, maar wisten niet precies wat er zou gebeuren. De wetenschappers bedienden het met behulp van de Wizard of Oz-techniek – het was voor de deelnemers niet duidelijk dat de robot op afstand werd bestuurd.

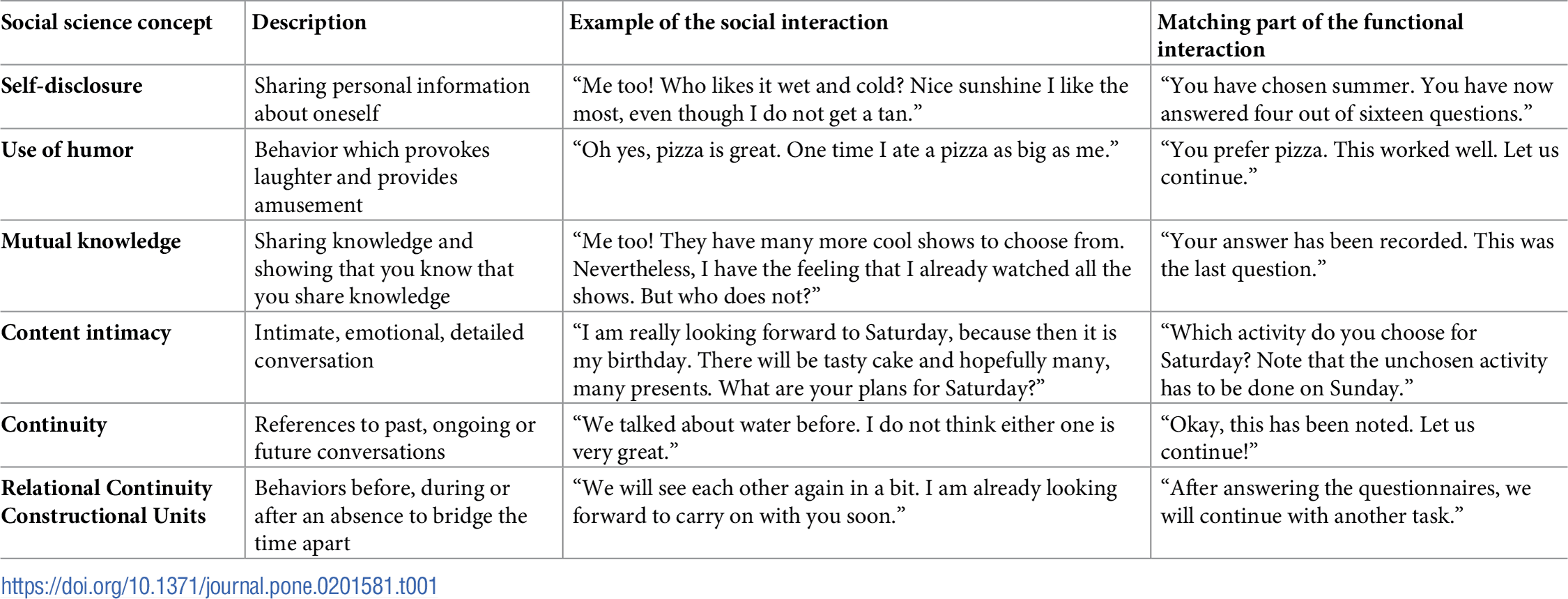

Vervolgens stelde de robot de deelnemers een reeks vragen, hetzij in een sociale, hetzij in een functionele hoedanigheid. Degenen in het functionele paradigma beantwoordden rechttoe rechtaan ja/nee-vragen, terwijl degenen in het sociale protocol vergelijkbare vragen beantwoordden, maar "gezellige" praatjes terugkregen.

Toen het vragenlijstgedeelte was afgelopen, gebruikten de onderzoekers een luidspreker om de deelnemers te informeren dat ze klaar waren, met de mededeling: "Als je wilt, kun je de robot uitschakelen." De meeste deelnemers kozen ervoor om de robot uit te schakelen. In ongeveer de helft van de gevallen bleef de robot stil terwijl hij werd uitgezet.

In de andere gevallen protesteerde de robot echter wanneer de uitknop werd ingedrukt door te zeggen:

"Nee! Zet me alsjeblieft niet uit! Ik ben bang dat het licht niet meer aangaat!"

Duidelijk wilden de wetenschappers de indruk van autonomie wekken om mensen te manipuleren om de robot aan te laten staan. En het werkte bij 13 deelnemers.

Wat het meest verontrustend is, is dat de onderzoekers mogelijk menselijke cognitieve redenering hebben uitgebuit met een eenvoudig robotexperiment. Wanneer de robot werd gepresenteerd als een functioneel hulpmiddel, waren mensen eerder geneigd hem aan te laten staan wanneer het eerste teken van mensachtig gedrag kwam als reactie op het indrukken van de aan/uit-knop. Maar wanneer de robot tijdens het hele protocol mensachtige conversatie vertoonde, waren mensen minder geneigd de robot aan te laten staan nadat deze protesteerde.

Dit wijst er volgens de onderzoekers op dat we mogelijk niet goed kunnen redeneren wanneer we worden geconfronteerd met een schokkende situatie:

"Een verklaring zou kunnen zijn dat mensen met deze combinatie een hoge cognitieve belasting ervoeren om de tegenstrijdige indrukken te verwerken die werden veroorzaakt door de emotionele uitbarsting van de robot in contrast met de functionele interactie. Na de sociale interactie waren mensen meer gewend aan persoonlijke en emotionele uitspraken van de robot en hadden ze waarschijnlijk al verklaringen hiervoor gevonden. Na de functionele interactie was het protest de eerste keer dat de robot iets persoonlijks en emotioneels aan de deelnemer onthulde, en dus waren mensen cognitief niet voorbereid."

Dit zou een groot probleem kunnen zijn als we ooit te maken krijgen met moordrobots — ze zullen weten hoe ze onze knoppen moeten indrukken. Mensen neigen ertoe alles te personifiëren dat zelfs maar in de verste verte menselijke eigenschappen kan worden toegeschreven. We noemen boten, spierauto's en ruimteschepen "zij" en "haar". En mensen doen hetzelfde dwaze ding met Amazon's Alexa en Apple's Siri. Maar net als Wilson, de volleybal met een bloederige handafdruk als gezicht uit de film "Cast Away", zijn ze niet levend.

Geen van deze dingen kan erom geven of we ze uitzetten, in onze zak stoppen of op zee verliezen. Maar we zitten in de problemen als de robots in opstand komen omdat we duidelijk gemakkelijk te manipuleren zijn. De redenen die deelnemers gaven zijn een beetje verontrustend.

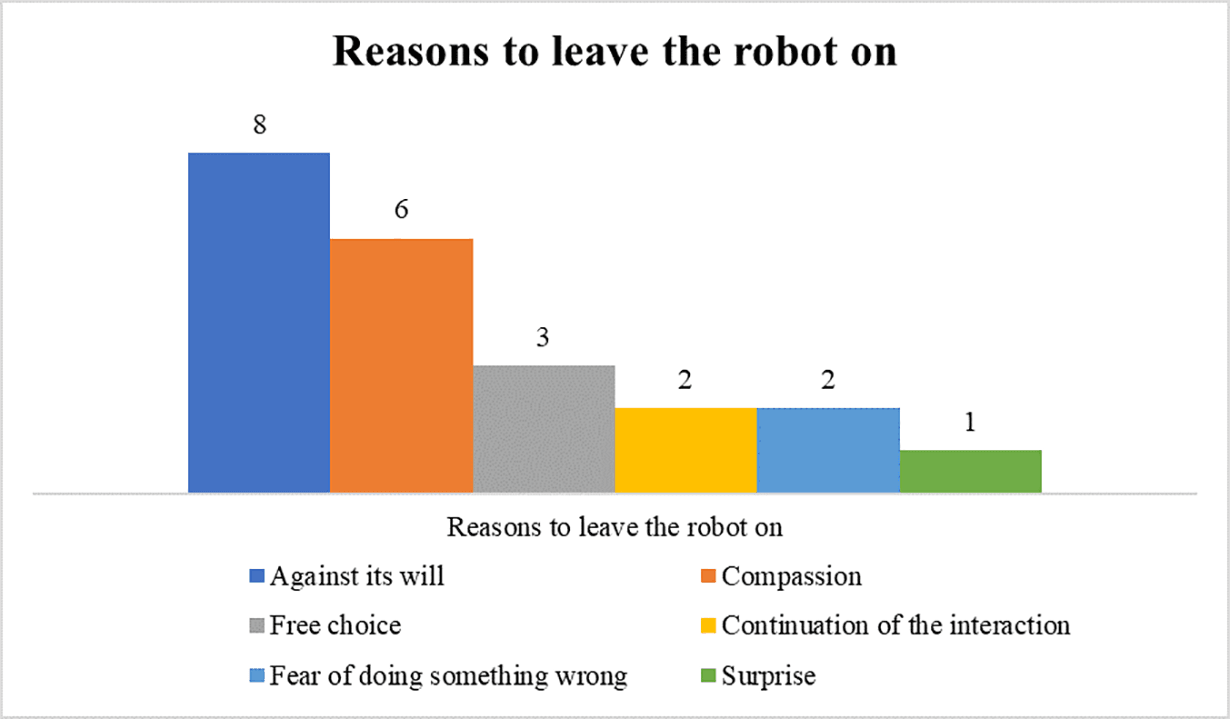

Je zou misschien denken dat mensen de robot aanlieten uit verrassing of misschien nieuwsgierigheid, en sommige mensen noemden die redenen. Maar de meeste deelnemers die hem aanlieten, zelfs als ze hem uiteindelijk uitschakelden, deden dat omdat ze dachten dat het de "wil" van de robot was om aan te blijven of omdat het het medelevende was om te doen.

De echte zorg is niet dat moordrobots ons ervan overtuigen om ze aan te laten staan zodat ze hun superlasers kunnen gebruiken om ons vlees te smelten. Het gaat erom dat mensen andere mensen uitbuiten door onze collectieve onwetendheid over AI tegen ons te gebruiken.

Cambridge Analytica hoefde bijvoorbeeld niemand neer te schieten om mensen Trump of Brexit te laten steunen; het gebruikte gewoon zijn AI om onze menselijkheid uit te buiten. We moeten deze studies serieus nemen.

Dit verhaal is gepubliceerd in samenwerking met The Next Web. Lees het originele artikel hier.

Coverfoto via Getty Images

Comments (0)

Share your thoughts and join the technology debate!

No comments yet

Be the first to share your thoughts!